phần mềm chỉnh sửa video

Xóa Bỏ Hiện Tượng Răng Cưa Với Plugin Aliasing Miễn Phí!

Bạn đam mê quay video hành động bằng GoPro, camera hành trình hay điện thoại? Chắc hẳn bạn đã từng khó chịu với hiện tượng răng cưa (aliasing) làm giảm chất lượng video. Đừng lo lắng, bài viết này sẽ “bật mí” bí quyết loại bỏ hiện tượng này một cách dễ dàng và hiệu quả, biến những thước phim của bạn trở nên mượt mà và chuyên nghiệp hơn bao giờ hết.

Plugin Aliasing Là Gì Và Tại Sao Nó “Ám Ảnh” Video Hành Động?

Định Nghĩa “Kẻ Phá Bĩnh” Aliasing

Aliasing, hay còn gọi là hiện tượng răng cưa, là một lỗi hiển thị hình ảnh khiến các đường thẳng và cạnh cong trở nên răng cưa, “gãy khúc” thay vì mượt mà tự nhiên. Hãy tưởng tượng bạn đang nhìn một đường chéo trên màn hình độ phân giải thấp, bạn sẽ thấy nó giống như một bậc thang hơn là một đường thẳng. Đó chính là aliasing.

Vì Sao Camera Hành Động Dễ Mắc Lỗi Aliasing?

Hiện tượng này thường xuất hiện trên video được quay bằng camera hành động, drone (flycam) và thậm chí cả điện thoại di động. Nguyên nhân chính nằm ở:

- Kích thước cảm biến nhỏ: Camera hành động thường có cảm biến nhỏ để đảm bảo kích thước nhỏ gọn. Cảm biến nhỏ thu thập ít thông tin hơn, dẫn đến khả năng tái tạo chi tiết hình ảnh kém, làm tăng nguy cơ aliasing.

- Độ sắc nét (Sharpening) cao: Để tạo ra những thước phim sắc nét và ấn tượng, các nhà sản xuất thường cài đặt mặc định độ sắc nét rất cao cho camera hành động. Tuy nhiên, việc tăng độ sắc nét quá mức lại vô tình làm nổi bật hiện tượng răng cưa.

- Thuật toán nén video: Để tiết kiệm dung lượng lưu trữ, video thường được nén lại. Quá trình nén có thể tạo ra các “artifact” (lỗi nén), khiến aliasing trở nên tồi tệ hơn.

Trước đây, cách duy nhất để giảm aliasing là sử dụng hiệu ứng Gaussian Blur (làm mờ) trong quá trình hậu kỳ. Tuy nhiên, phương pháp này có nhược điểm lớn: nó làm mờ toàn bộ khung hình, làm mất đi những chi tiết sắc nét mà bạn muốn giữ lại.

Gaussian Blur Hoạt Động Ra Sao?

Về cơ bản, Gaussian Blur làm mịn hình ảnh bằng cách làm mờ các pixel xung quanh mỗi điểm ảnh. Điều này giúp làm giảm sự tương phản giữa các pixel, làm mờ các cạnh răng cưa.

Nhược Điểm Cần Cân Nhắc

Mặc dù Gaussian Blur có thể giảm aliasing, nhưng nó cũng làm giảm độ sắc nét tổng thể của video. Điều này có thể khiến video của bạn trông mềm mại và thiếu chi tiết.

Xem thêm:

Tạo Video AI Chất Lượng Cao với Hunyuan Video và ComfyUI

Biến Ảnh Thường Thành Tuyệt Tác: Thủ Thuật Xóa Phông Nền “Thần Sầu” với ComfyUI

Tin vui là giờ đây chúng ta đã có một giải pháp tốt hơn: FXAA (Fast Approximate Anti-Aliasing). Đây là một plugin miễn phí dành cho After Effects, được phát triển bởi Plugin Everything. FXAA hoạt động bằng cách phân tích các pixel trong video và sử dụng thuật toán dò cạnh để xác định các khu vực bị răng cưa. Sau đó, nó sẽ áp dụng một lớp làm mờ thông minh chỉ ở những khu vực này, giúp làm mịn các cạnh răng cưa mà không làm ảnh hưởng đến độ sắc nét của các chi tiết khác trong video.

Tại Sao FXAA Lại “Vượt Mặt” Gaussian Blur?

- Hiệu quả cao: FXAA tập trung vào việc làm mịn các cạnh răng cưa mà không làm mờ toàn bộ khung hình, giúp giữ lại độ sắc nét và chi tiết của video.

- Tốc độ xử lý nhanh: FXAA được thiết kế để chạy nhanh, ngay cả trên các máy tính cấu hình không quá mạnh. Điều này rất quan trọng khi xử lý video hành động có độ phân giải cao.

- Dễ sử dụng: FXAA rất dễ cài đặt và sử dụng. Chỉ với vài thao tác đơn giản, bạn đã có thể cải thiện đáng kể chất lượng video của mình.

- Miễn phí: Điều tuyệt vời nhất là FXAA hoàn toàn miễn phí! Bạn không cần phải trả bất kỳ khoản phí nào để sử dụng plugin này.

Hướng Dẫn Sử Dụng FXAA Từng Bước

- Tải và cài đặt plugin FXAA: Truy cập trang web của Plugin Everything và tải plugin FXAA miễn phí. Sau đó, làm theo hướng dẫn để cài đặt plugin vào After Effects.

- Áp dụng FXAA cho video: Mở After Effects và nhập video hành động của bạn vào. Tạo một composition mới và thêm video vào composition.

- Tìm và áp dụng hiệu ứng FXAA: Trong bảng Effects & Presets, tìm kiếm “FXAA” và kéo hiệu ứng này vào layer video của bạn.

- Điều chỉnh thông số (tùy chọn): FXAA có một vài thông số điều chỉnh, nhưng bạn thường không cần phải thay đổi chúng. Nếu muốn, bạn có thể thử nghiệm với các thông số này để đạt được kết quả tốt nhất.

- Render video: Sau khi đã áp dụng FXAA, render video của bạn để xem kết quả.

Mẹo nhỏ: Bạn có thể áp dụng nhiều layer FXAA để tăng hiệu quả khử răng cưa. Tuy nhiên, hãy cẩn thận để không làm mất quá nhiều chi tiết của video.

Ngoài việc khử răng cưa, còn rất nhiều cách khác để cải thiện chất lượng video hành động của bạn. Ví dụ, bạn có thể sử dụng các phần mềm ổn định hình ảnh (ví dụ như ReelSteady GO) để loại bỏ rung lắc, hoặc điều chỉnh màu sắc để tạo ra những thước phim sống động và ấn tượng hơn.

Với plugin FXAA miễn phí, việc xóa bỏ răng cưa, nâng tầm chất lượng video hành động trở nên dễ dàng hơn bao giờ hết. Hãy tải ngay FXAA và trải nghiệm sự khác biệt!

phần mềm chỉnh sửa video

Chuyển Văn Bản Thành Video Miễn Phí với Stable Diffusion

Bạn đã bao giờ mơ ước biến những dòng chữ khô khan thành những thước phim sống động? Giờ đây, với sự trợ giúp của trí tuệ nhân tạo (AI) và công cụ Stable Diffusion, điều đó hoàn toàn có thể thực hiện được, và quan trọng hơn, hoàn toàn miễn phí! Bài viết này sẽ đưa bạn khám phá thế giới kỳ diệu của việc chuyển đổi văn bản thành video (text-to-video), một lĩnh vực đang phát triển mạnh mẽ với những ứng dụng tiềm năng vô tận.

Giải Mã Cơn Sốt Chuyển Văn Bản Thành Video (Text-to-Video): Tại Sao Ai Cũng Muốn Thử?

Text-to-video không chỉ là một trào lưu công nghệ nhất thời, mà là một bước tiến lớn trong việc dân chủ hóa quy trình sáng tạo nội dung. Trước đây, việc tạo ra một video chất lượng đòi hỏi kỹ năng chuyên môn, phần mềm đắt tiền và thời gian đầu tư đáng kể. Nhưng giờ đây, bất kỳ ai có một ý tưởng và một vài dòng mô tả đều có thể tạo ra một video độc đáo.

Ứng dụng của text-to-video rất đa dạng:

- Marketing và quảng cáo: Tạo ra các video quảng cáo ngắn, thu hút mà không cần đến đội ngũ sản xuất chuyên nghiệp.

- Giáo dục và đào tạo: Biến các bài giảng, hướng dẫn thành các video minh họa sinh động, giúp người học dễ tiếp thu hơn.

- Nghệ thuật và giải trí: Tạo ra các video nghệ thuật độc đáo, thử nghiệm với các phong cách và ý tưởng mới lạ.

- Truyền thông và báo chí: Tạo ra các video tóm tắt tin tức, báo cáo sự kiện một cách nhanh chóng và trực quan.

Với tiềm năng to lớn như vậy, không có gì ngạc nhiên khi text-to-video đang trở thành một lĩnh vực được quan tâm đặc biệt.

Xem thêm:

AnimateDiff: Biến Văn Bản Thành Video Dễ Dàng – Hướng Dẫn Chi Tiết Cho Người Việt

Biến Video Thường Thành Phiên Bản AI Độc Đáo: Khám Phá AnimateDiff Prompt Travel!

Stable Diffusion là một mô hình AI mã nguồn mở, nổi tiếng với khả năng tạo ra hình ảnh chất lượng cao từ văn bản. Gần đây, Stable Diffusion đã được mở rộng để hỗ trợ tạo video, mở ra một kỷ nguyên mới cho việc sáng tạo nội dung.

Điều gì khiến Stable Diffusion trở nên đặc biệt?

- Mã nguồn mở: Điều này có nghĩa là bất kỳ ai cũng có thể sử dụng, sửa đổi và phân phối Stable Diffusion một cách tự do.

- Khả năng tùy biến cao: Bạn có thể tùy chỉnh Stable Diffusion để tạo ra các video với phong cách và nội dung khác nhau.

- Cộng đồng hỗ trợ lớn: Có một cộng đồng lớn mạnh gồm các nhà phát triển và người dùng Stable Diffusion, sẵn sàng chia sẻ kiến thức và kinh nghiệm.

Với Stable Diffusion, bạn không chỉ tạo ra video, bạn còn có thể kiểm soát quá trình sáng tạo và biến những ý tưởng độc đáo nhất thành hiện thực.

Hướng Dẫn Chi Tiết: Biến Văn Bản Thành Video với Stable Diffusion (Miễn Phí!)

Để bắt đầu hành trình sáng tạo video của bạn với Stable Diffusion, bạn cần chuẩn bị một số công cụ và kiến thức cơ bản.

Bước 1: Chuẩn Bị Phần Mềm và Môi Trường

Bạn sẽ cần cài đặt AUTOMATIC1111, một giao diện người dùng đồ họa (GUI) phổ biến cho Stable Diffusion. AUTOMATIC1111 hoạt động trên Windows, Mac và Google Colab. Nếu bạn là người mới bắt đầu, hãy tham khảo hướng dẫn cài đặt nhanh để có cái nhìn tổng quan về Stable Diffusion.

Bước 2: Chọn Phương Pháp Chuyển Văn Bản Thành Video

Hiện tại, có ba phương pháp chính để chuyển văn bản thành video với Stable Diffusion:

- AnimateDiff: Một module được huấn luyện đặc biệt để tạo ra các chuyển động mượt mà và tự nhiên trong video.

- ModelScope: Một mô hình text-to-video dựa trên diffusion, được phát triển bởi Alibaba.

- Deforum: Một công cụ mạnh mẽ để tạo ra các video hoạt hình phức tạp với nhiều tùy chọn tùy chỉnh.

Chúng ta sẽ đi sâu vào từng phương pháp này để bạn có thể lựa chọn phương pháp phù hợp nhất với nhu cầu của mình.

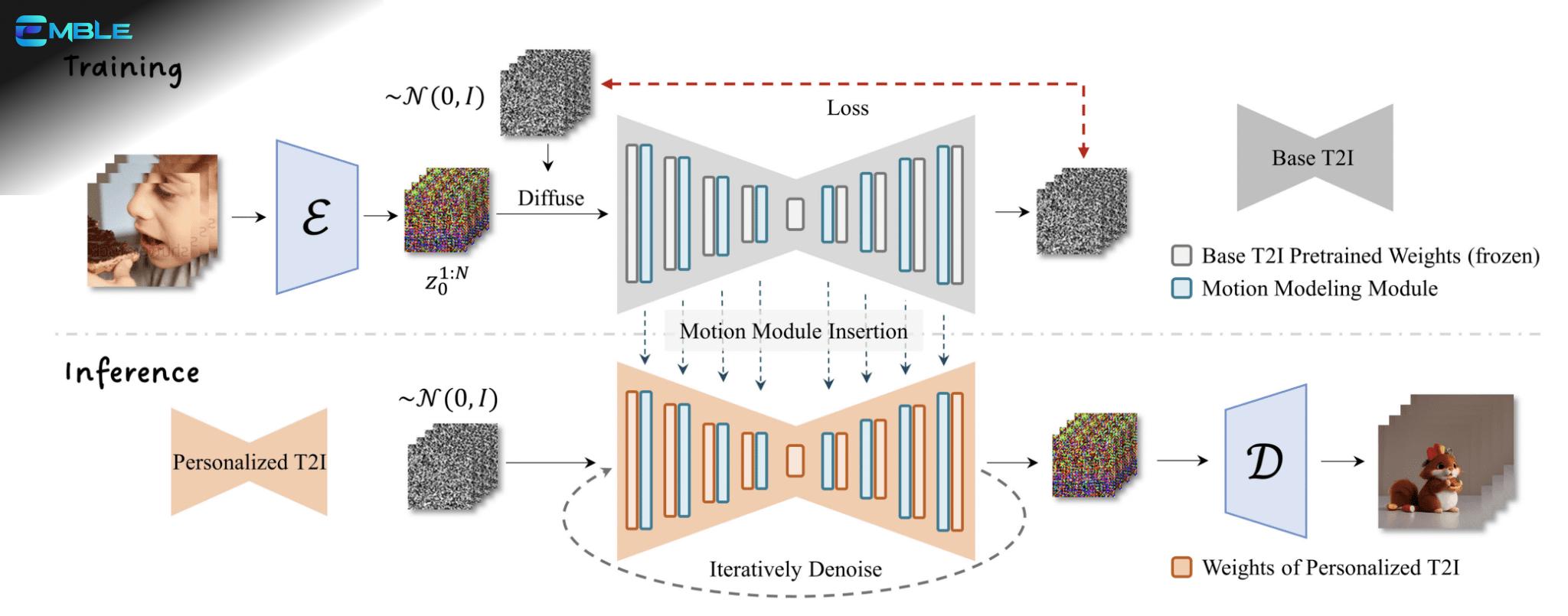

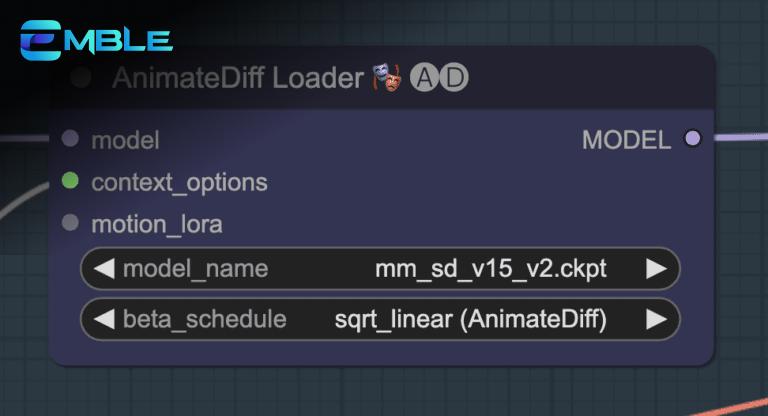

3.1. AnimateDiff: Thổi Hồn Vào Từng Khung Hình

AnimateDiff là một module text-to-video dành cho Stable Diffusion, được huấn luyện bằng cách cho mô hình xem các đoạn video ngắn. Nhờ đó, AnimateDiff học được cách dự đoán khung hình tiếp theo trong video nên như thế nào. AnimateDiff thêm module chuyển động vào bộ dự đoán nhiễu U-Net của mô hình Stable Diffusion để tạo video dựa trên mô tả bằng văn bản.

Cài đặt AnimateDiff

- Google Colab: Chọn AnimateDiff trong danh sách các extension có sẵn.

- Windows/Mac:

- Khởi động AUTOMATIC1111.

- Vào trang Extension.

- Chọn tab Install from URL.

- Nhập URL sau vào ô URL for extension’s git repository:

https://github.com/continue-revolution/sd-webui-animatediff - Đợi thông báo cài đặt thành công.

- Tải các motion model của AnimateDiff từ Hugging Face và lưu vào thư mục

stable-diffusion-webui > extensions > sd-webui-animatediff > model.- Link tải trực tiếp cho v1.5 v2 motion model:

https://huggingface.co/guoyww/animatediff/resolve/main/mm_sd_v15_v2.ckpt - Link tải trực tiếp cho v1.4 motion model:

https://huggingface.co/guoyww/animatediff/resolve/main/mm_sd_v14.ckpt - Link tải trực tiếp cho v1.5 motion model:

https://huggingface.co/guoyww/animatediff/resolve/main/mm_sd_v15.ckpt

- Link tải trực tiếp cho v1.5 v2 motion model:

- Khởi động lại Web-UI.

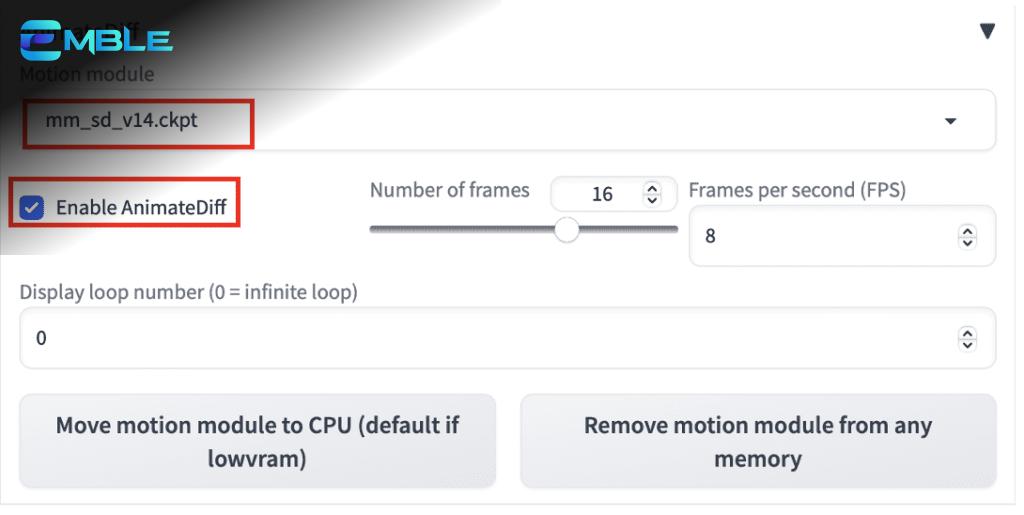

Sử dụng AnimateDiff

- Trong AUTOMATIC1111, vào trang txt2img.

- Trong phần AnimateDiff:

- Enable AnimateDiff: Chọn “Yes”.

- Motion Module: Chọn motion module bạn muốn sử dụng (v1.4 tạo ra nhiều chuyển động hơn, v1.5 tạo ra ảnh rõ nét hơn).

- Nhập prompt và negative prompt như bình thường. Ví dụ:

- Prompt: 1girl, looking at viewer, anime, cherry blossoms

- Negative prompt: disfigured, deformed, ugly

- Chọn model Stable Diffusion v1. Ví dụ: Anything v3.

- CFG: Đặt giá trị cao (10 – 25).

- Sampler: DPM++ 2M Karass.

Mẹo Sử Dụng AnimateDiff

- Tăng CFG scale nếu ảnh bị xám.

- Đổi motion module (v1.4 và v1.5) nếu thấy watermark trên ảnh.

- Sử dụng LoRA với AnimateDiff.

- Giữ số lượng frame ở mức 16 để có hiệu suất tốt nhất.

- Thay đổi prompt nếu bạn thấy hai video ngắn trong một.

3.2. ModelScope: Sức Mạnh Đến Từ Alibaba

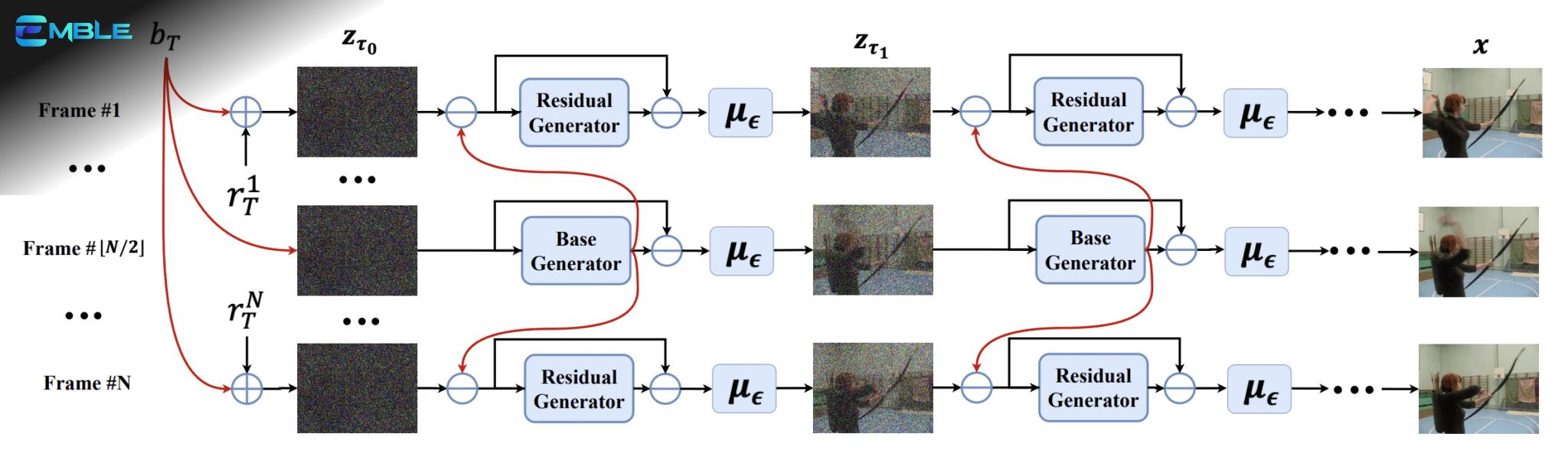

ModelScope là một mô hình text-to-video dựa trên diffusion. Ý tưởng chính của ModelScope là các khung hình của một video thường rất giống nhau. Modelscope là một mô hình latent diffusion. Khung hình đầu tiên bắt đầu dưới dạng một tensor nhiễu ẩn, giống như text-to-image của Stable Diffusion. Điểm mới lạ là mô hình này chia nhiễu thành hai phần: (1) nhiễu cơ bản và (2) nhiễu dư. Nhiễu cơ bản được chia sẻ trên TẤT CẢ các khung hình. Nhiễu dư thay đổi trong mỗi khung hình.

Cài đặt ModelScope

Bạn cần cài đặt extension text2video.

- Google Colab: Chọn extension text2video trong danh sách.

- Windows/Mac:

- Khởi động AUTOMATIC1111.

- Vào trang Extension.

- Chọn tab Install from URL.

- Nhập URL sau vào ô URL for extension’s git repository:

https://github.com/kabachuha/sd-webui-text2video - Đợi thông báo cài đặt thành công.

- Khởi động lại webUI hoàn toàn.

- Tạo cấu trúc thư mục sau:

stable-diffusion-webui\models\text2video\t2v. - Tải các file model text-to-video tại đây và đặt chúng vào thư mục

t2v. Bạn cần 4 file sau:- VQGAN_autoencoder.pth

- configuration.json

- openclippytorch_model.bin

- text2videopytorchmodel.pth

Sử dụng ModelScope

- Trong AUTOMATIC1111, vào trang txt2video.

- Model type: Chọn “ModelScope”.

- Model: Chọn “t2v”.

- Prompt: Nhập prompt mô tả video. Ví dụ: a lion and a man in a suit fighting

- Điều chỉnh Frames để kiểm soát độ dài video.

- Nhấn Generate và đợi hoàn thành. Nhấn Update the video.

Mẹo Sử Dụng ModelScope

- Sử dụng kích thước video 256×256 cho model cơ bản. Các kích thước khác có thể không hoạt động tốt.

- Mô tả những gì bạn muốn THẤY trong video.

- Sử dụng chức năng img2vid để điều chỉnh khung hình ban đầu.

3.3. Deforum: Biến Ý Tưởng Thành Phim Hoạt Hình

Deforum tạo video bằng cách sử dụng các mô hình Stable Diffusion. Nó đạt được tính nhất quán của video thông qua img2img trên các khung hình. Vì đầu vào là nhiều prompt văn bản, nó đủ điều kiện là một pipeline text-to-video.

Cài đặt Deforum

Deforum thường được cài đặt như một extension cho AUTOMATIC1111. Bạn có thể tìm thấy hướng dẫn cài đặt chi tiết trên trang chủ của Deforum hoặc trong cộng đồng Stable Diffusion.

Sử dụng Deforum

Deforum có giao diện phức tạp hơn so với AnimateDiff và ModelScope, nhưng nó cũng cung cấp nhiều tùy chọn tùy chỉnh hơn. Bạn có thể kiểm soát các yếu tố như chuyển động của camera, sự thay đổi của prompt theo thời gian và các hiệu ứng đặc biệt.

Mẹo Sử Dụng Deforum

- Tìm hiểu kỹ các thông số của Deforum để tận dụng tối đa sức mạnh của nó.

- Tham khảo các video hướng dẫn và chia sẻ kinh nghiệm từ cộng đồng Deforum.

- Thử nghiệm với các phong cách và kỹ thuật khác nhau để tạo ra những video độc đáo.

Dưới đây là một số mẹo giúp bạn tạo ra những video chất lượng cao hơn với Stable Diffusion:

- Prompting là chìa khóa: Viết prompt rõ ràng, chi tiết và sáng tạo.

- Thử nghiệm với các model khác nhau: Mỗi model Stable Diffusion có một phong cách riêng.

- Sử dụng negative prompt: Loại bỏ những yếu tố không mong muốn trong video.

- Điều chỉnh các thông số: Tìm hiểu các thông số quan trọng và điều chỉnh chúng để đạt được kết quả tốt nhất.

- Kiên nhẫn và sáng tạo: Text-to-video là một quá trình thử nghiệm. Hãy kiên nhẫn và đừng ngại thử những ý tưởng mới.

Stable Diffusion đã mở ra một kỷ nguyên mới cho việc sáng tạo video, cho phép bất kỳ ai cũng có thể biến những ý tưởng trong đầu thành những thước phim sống động. Bằng cách tận dụng sức mạnh của AI và các công cụ như AnimateDiff, ModelScope và Deforum, bạn có thể tạo ra những video độc đáo và ấn tượng. Hãy sẵn sàng khám phá thế giới kỳ diệu của text-to-video và biến điều không tưởng thành hiện thực!

phần mềm chỉnh sửa video

Biến Video Thường Thành Phiên Bản AI Độc Đáo: Khám Phá AnimateDiff Prompt Travel!

Bạn có bao giờ tự hỏi làm thế nào để biến những thước phim nhàm chán thành những tác phẩm nghệ thuật đầy sáng tạo và độc đáo? Với sự trỗi dậy của trí tuệ nhân tạo (AI), giờ đây bạn có thể dễ dàng biến video thông thường thành những phiên bản hoàn toàn mới lạ chỉ bằng vài thao tác đơn giản. Trong bài viết này, chúng ta sẽ cùng nhau khám phá một kỹ thuật đột phá mang tên AnimateDiff Prompt Travel, một công cụ mạnh mẽ giúp bạn tạo ra những video liền mạch, nhất quán và đầy biến hóa bằng cách sử dụng một video khác làm tham chiếu.

AnimateDiff Prompt Travel Là Gì?

AnimateDiff Prompt Travel là một kỹ thuật sử dụng AI để tạo ra các video có tính nhất quán cao về mặt thời gian và hình ảnh, đồng thời cho phép bạn thay đổi nội dung và phong cách của video theo thời gian bằng cách sử dụng các “prompt” khác nhau. Nói một cách đơn giản, bạn có thể lấy một video bất kỳ, ví dụ như một người đang nhảy múa, và biến nó thành một video hoàn toàn mới với bối cảnh và phong cách khác nhau, ví dụ như người đó đang nhảy múa trên bãi biển, trong vũ trụ, hoặc thậm chí là trong một thế giới hoạt hình.

Kỹ thuật này dựa trên sự kết hợp của ba yếu tố chính:

- AnimateDiff: Công cụ tạo chuyển động video bằng các mô hình Stable Diffusion, đảm bảo tính nhất quán về mặt thời gian.

- ControlNet: Sử dụng video tham chiếu để điều khiển chuyển động và dáng điệu của đối tượng trong video mới.

- Prompt Travel: Thay đổi prompt (lời nhắc) theo thời gian để tạo ra sự đa dạng và biến hóa trong video.

Ưu Điểm Vượt Trội Của AnimateDiff Prompt Travel

So với các kỹ thuật tạo video AI khác, AnimateDiff Prompt Travel sở hữu nhiều ưu điểm vượt trội:

- Tính nhất quán cao: AnimateDiff đảm bảo video được tạo ra có tính nhất quán cao về mặt thời gian, tránh tình trạng giật lag hoặc biến dạng hình ảnh.

- Khả năng điều khiển linh hoạt: ControlNet cho phép bạn điều khiển chuyển động và dáng điệu của đối tượng trong video mới dựa trên video tham chiếu.

- Sáng tạo không giới hạn: Prompt Travel cho phép bạn thay đổi nội dung và phong cách của video theo thời gian, mở ra khả năng sáng tạo vô tận.

- Dễ sử dụng: Với sự hỗ trợ của ComfyUI, việc tạo video bằng AnimateDiff Prompt Travel trở nên dễ dàng hơn bao giờ hết.

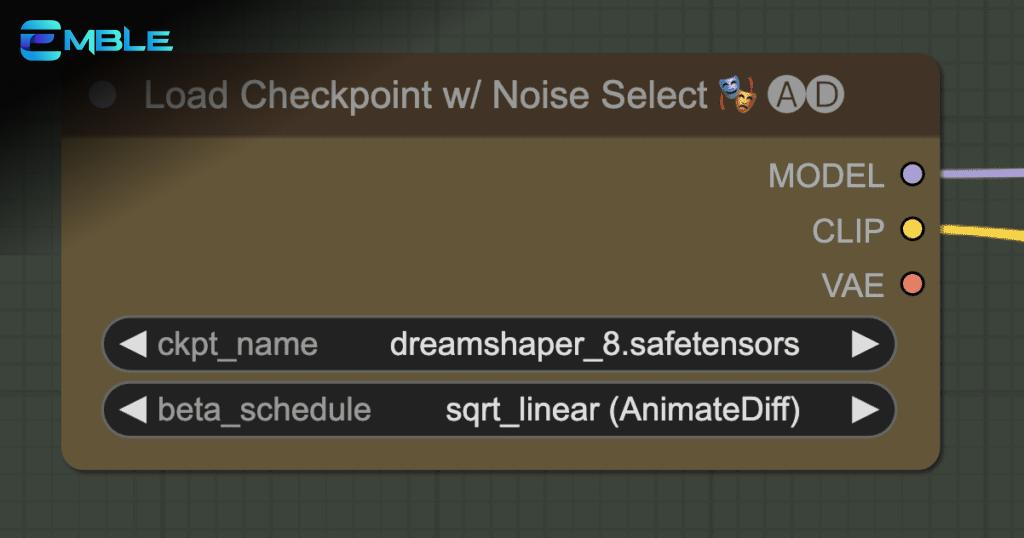

Để bắt đầu hành trình sáng tạo video AI với AnimateDiff Prompt Travel, chúng ta sẽ sử dụng ComfyUI, một giao diện người dùng đồ họa mạnh mẽ và linh hoạt. Dưới đây là hướng dẫn chi tiết từng bước:

Bước 1: Cài Đặt Phần Mềm Cần Thiết

Trước khi bắt đầu, bạn cần đảm bảo đã cài đặt các phần mềm sau:

- ComfyUI: Tải và cài đặt ComfyUI theo hướng dẫn trên trang chủ ComfyUI.

- ComfyUI Manager: Cài đặt ComfyUI Manager để quản lý và cài đặt các node tùy chỉnh.

Bước 2: Tải Workflow ComfyUI

Tải xuống workflow JSON ComfyUI cho AnimateDiff Prompt Travel. Bạn có thể tìm thấy workflow này trên các diễn đàn hoặc trang web chia sẻ tài nguyên AI.

Bước 3: Cài Đặt Các Node Bị Thiếu

Mở ComfyUI và kéo thả file workflow JSON vừa tải xuống vào giao diện. Nếu có bất kỳ node nào bị thiếu, ComfyUI Manager sẽ tự động thông báo và cho phép bạn cài đặt chúng.

Bước 4: Chọn Checkpoint Model

Chọn một checkpoint model phù hợp với phong cách video bạn muốn tạo. Bạn có thể tải các checkpoint model từ các trang web như Civitai hoặc Hugging Face. Đặt file checkpoint model vào thư mục ComfyUI > models > checkpoints.

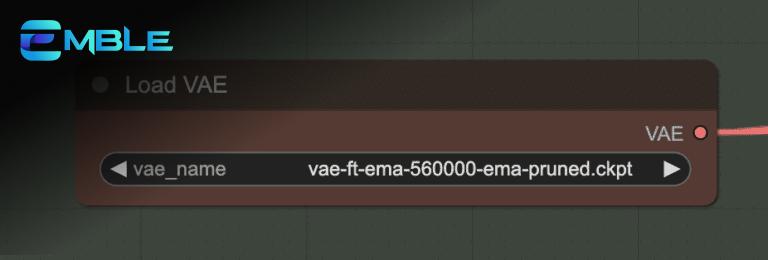

Bước 5: Chọn VAE

Chọn một VAE (Variational Autoencoder) tương ứng với checkpoint model bạn đã chọn. VAE giúp cải thiện chất lượng hình ảnh và màu sắc của video. Đặt file VAE vào thư mục ComfyUI > models > vae.

Bước 6: Chọn AnimateDiff Motion Module

Chọn một motion module cho AnimateDiff. Motion module quyết định cách chuyển động được tạo ra trong video. Đặt file motion module vào thư mục ComfyUI > custom_nodes > ComfyUIAnimateDiffEvolved > models.

Bước 7: Chọn Openpose ControlNet Model

Chọn Openpose ControlNet model để trích xuất dáng điệu của người từ video gốc. Đặt file ControlNet model vào thư mục ComfyUI > models > controlnet.

Bước 8: Tải Video Tham Chiếu

Tải video bạn muốn sử dụng làm tham chiếu lên ComfyUI. Video này sẽ được sử dụng để điều khiển chuyển động và dáng điệu của đối tượng trong video mới.

Bước 9: Thiết Lập Prompt

Thiết lập prompt (lời nhắc) cho video. Bạn có thể sử dụng một prompt duy nhất cho toàn bộ video hoặc sử dụng “prompt travel” để thay đổi prompt theo thời gian, tạo ra sự đa dạng và biến hóa.

Bước 10: Tạo Video

Nhấn nút “Queue Prompt” để bắt đầu quá trình tạo video. Thời gian tạo video phụ thuộc vào độ dài của video, độ phức tạp của prompt và cấu hình máy tính của bạn.

Trong quá trình sử dụng AnimateDiff Prompt Travel, bạn có thể gặp phải một số sự cố. Dưới đây là một số cách khắc phục thường gặp:

- Lỗi thiếu node: Đảm bảo bạn đã cài đặt tất cả các node cần thiết bằng ComfyUI Manager.

- Video bị giật lag: Giảm số lượng frame hoặc giảm độ phân giải của video.

- Hình ảnh bị biến dạng: Thay đổi checkpoint model hoặc VAE.

- Chuyển động không tự nhiên: Điều chỉnh motion module hoặc prompt.

AnimateDiff Prompt Travel cho phép bạn tùy biến video theo nhiều cách khác nhau:

- Thay đổi đối tượng: Thay đổi prompt để thay đổi đối tượng trong video.

- Thay đổi bối cảnh: Thay đổi prompt để thay đổi bối cảnh trong video.

- Thay đổi phong cách: Thay đổi checkpoint model và VAE để thay đổi phong cách của video.

- Sử dụng ControlNet khác: Thử nghiệm với các ControlNet khác nhau để điều khiển video theo những cách độc đáo.

Mẹo Sử Dụng AnimateDiff Prompt Travel Hiệu Quả

Để tạo ra những video ấn tượng với AnimateDiff Prompt Travel, hãy lưu ý những mẹo sau:

- Chọn video tham chiếu phù hợp: Video tham chiếu nên có chất lượng tốt và chứa chuyển động rõ ràng.

- Sử dụng prompt chi tiết: Prompt càng chi tiết, video được tạo ra càng giống với ý tưởng của bạn.

- Thử nghiệm với các cài đặt khác nhau: Đừng ngại thử nghiệm với các cài đặt khác nhau để tìm ra những kết quả độc đáo.

- Kiên nhẫn: Quá trình tạo video AI có thể mất nhiều thời gian, đặc biệt là với những video dài và phức tạp.

AnimateDiff Prompt Travel mở ra một kỷ nguyên mới cho việc sáng tạo video AI, kết hợp sức mạnh của AnimateDiff và kỹ thuật Prompt Engineering giúp bạn dễ dàng biến những ý tưởng độc đáo thành hiện thực, tạo ra những video chất lượng cao và đầy tính nghệ thuật.

phần mềm chỉnh sửa video

Biến Ảnh Tĩnh Thành Phim: Tạo Video SVD Dễ Dàng Với SD Forge!

Bạn đã bao giờ mơ ước biến những bức ảnh tĩnh thành những thước phim sống động? Giờ đây, với Stable Diffusion WebUI Forge (SD Forge), giấc mơ đó đã trở thành hiện thực! Bài viết này sẽ hướng dẫn bạn từng bước cách tạo ra những video Stable Video Diffusion (SVD) ấn tượng, ngay cả khi bạn là người mới bắt đầu.

Cập nhật: 19 tháng 05, 2024 | Tác giả: (Tên của bạn – Ví dụ: Nguyễn Văn A), Chuyên gia Công nghệ & SEO, Nhà báo

SD Forge là Gì và Tại Sao Bạn Nên Sử Dụng?

SD Forge là một giao diện mạnh mẽ, cho phép bạn tạo video SVD một cách trực quan và dễ dàng. Không cần phải vật lộn với các dòng lệnh phức tạp, tất cả những gì bạn cần đều nằm trong giao diện đồ họa (GUI) thân thiện. SD Forge cung cấp quyền truy cập vào tất cả các cài đặt nâng cao, giúp bạn tùy chỉnh video theo ý muốn.

Stable Video Diffusion (SVD) là một kỹ thuật đột phá, cho phép biến một hình ảnh tĩnh thành một video ngắn, mượt mà và đầy ấn tượng. Công nghệ này mở ra những khả năng sáng tạo vô tận, từ việc tạo hiệu ứng chuyển động cho ảnh chân dung đến việc hình dung những ý tưởng nghệ thuật độc đáo.

Trước khi bắt đầu hành trình sáng tạo video, bạn cần chuẩn bị một số công cụ cần thiết:

Cài Đặt SD Forge: “Nhập Môn” Thế Giới Stable Diffusion

Nếu bạn chưa cài đặt SD Forge, hãy làm theo hướng dẫn chi tiết tại [liên kết hướng dẫn cài đặt SD Forge]. Quá trình cài đặt khá đơn giản và nhanh chóng, đảm bảo bạn sẽ sẵn sàng chỉ trong vài phút.

Nếu bạn là người mới làm quen với Stable Diffusion, đừng lo lắng! Hãy tham khảo [hướng dẫn nhanh Stable Diffusion] để nắm bắt những kiến thức cơ bản.

Muốn trở thành “phù thủy” Stable Diffusion? Hãy tham gia [khóa học Stable Diffusion] để học hỏi một cách bài bản và chuyên sâu.

Tải Xuống và Cài Đặt Mô Hình SVD: “Trái Tim” Của Quá Trình Tạo Video

Để SD Forge có thể tạo video SVD, bạn cần cài đặt mô hình SVD XT.

- Đọc và chấp nhận thỏa thuận sử dụng tại [liên kết thỏa thuận sử dụng mô hình SVD].

- Tải xuống mô hình SVD 1.1 từ [liên kết tải mô hình SVD 1.1].

- Sao chép mô hình vào thư mục “svd” trong thư mục cài đặt SD Forge. Đường dẫn đầy đủ thường là:

webui_forge_cu121_torch21 > webui > models > svd. - Khởi động lại SD Forge: Nếu SD Forge đang chạy, hãy đóng hoàn toàn và khởi động lại để hệ thống nhận diện mô hình mới.

Giờ thì đến phần thú vị nhất: tạo video SVD!

Bước 1: Tạo Ảnh Gốc: “Nền Tảng” Của Video

Video SVD được tạo ra dựa trên một ảnh gốc. Hãy tạo một hình ảnh có kích thước 576 x 1024 pixel. Bạn có thể sử dụng bất kỳ mô hình checkpoint nào, nhưng chúng tôi khuyến nghị sử dụng [juggernautXL_v7].

- Prompt ví dụ:

a woman with long hair windy and tattoos on her body, a green shirt , Clint Cearley, epic fantasy character art, cyberpunk art, fantasy art(Một người phụ nữ tóc dài, có gió thổi và hình xăm trên cơ thể, mặc áo xanh, phong cách Clint Cearley, nghệ thuật giả tưởng sử thi, nghệ thuật cyberpunk, nghệ thuật giả tưởng) - Sampling method (Phương pháp lấy mẫu): DPM++ 2M Karras

- Sampling Steps (Số bước lấy mẫu): 20

- CFG scale (Tỷ lệ CFG): 7

- Seed (Hạt giống): -1

- Size (Kích thước): 576×1024

Trong prompt, hãy sử dụng các từ khóa gợi ý chuyển động, ví dụ như “windy” (có gió) để tạo hiệu ứng tóc bay, giúp video trở nên sống động hơn.

Sau khi tạo ảnh, hãy nhấn nút Send to SVD (Gửi đến SVD) bên dưới ảnh.

Bước 2: Tạo Video SVD: “Phép Màu” Thực Sự

Bạn sẽ được chuyển đến tab SVD.

- Kiểm tra checkpoint: Đảm bảo mô hình SVD đã được chọn.

- Cài đặt mặc định: Bạn có thể giữ nguyên các cài đặt mặc định cho lần thử đầu tiên.

- Nhấn Generate: Nhấn nút Generate (Tạo) và chờ đợi phép màu xảy ra!

Chỉ trong vài phút, bạn sẽ có một video SVD tuyệt đẹp, được tạo ra từ bức ảnh tĩnh của bạn.

Để tạo ra những video SVD độc đáo và phù hợp với ý tưởng của bạn, hãy làm quen với các thông số sau:

Motion Bucket ID: “Điều Khiển” Chuyển Động

Motion bucket id (ID thùng chuyển động) quyết định mức độ chuyển động trong video. Giá trị càng cao, chuyển động càng nhiều. Phạm vi giá trị từ 0 đến 255.

FPS: “Nhịp Điệu” Của Video

Frames per second (FPS – Số khung hình trên giây) kiểm soát số lượng khung hình mà mô hình tạo ra. Để có hiệu suất tốt nhất, hãy giữ giá trị này trong khoảng từ 5 đến 30.

Augmentation Level: “Nâng Cấp” Hình Ảnh

Augmentation level (Mức độ tăng cường) là lượng nhiễu được thêm vào ảnh gốc. Sử dụng thông số này để thay đổi ảnh gốc nhiều hơn hoặc khi tạo video có kích thước khác với kích thước mặc định.

Ngoài SD Forge, bạn cũng có thể sử dụng SVD trên:

- ComfyUI

- Google Colab

- Máy tính cá nhân (dưới dạng ứng dụng độc lập)

Tham khảo hướng dẫn chi tiết tại [liên kết hướng dẫn sử dụng SVD].

-

Các phần mềm nâng cao ảnh bằng AI10 tháng ago

Các phần mềm nâng cao ảnh bằng AI10 tháng agoCodeFormer & ComfyUI: “Cứu Tinh” Cải Thiện Chất Lượng Khuôn Mặt

-

Tin Nhanh11 tháng ago

Tin Nhanh11 tháng agoKhám Phá Bí Mật Làm Mờ Nền Video: Tạo Hiệu Ứng Độc Đáo Cho Video Của Bạn

-

phần mềm chỉnh sửa video9 tháng ago

phần mềm chỉnh sửa video9 tháng agoChuyển Động Cho Video với Kling Ai

-

Tin Nhanh11 tháng ago

Tin Nhanh11 tháng agoKhám Phá Những Công Cụ Giảm Dung Lượng Video Tuyệt Vời Mà Bạn Không Thể Bỏ Lỡ

-

Tin Nhanh11 tháng ago

Tin Nhanh11 tháng agoKhám Phá Thế Giới Phần Mềm Tạo Hoạt Hình Video: Bí Kíp Tạo Ra Những Thước Phim Ấn Tượng

-

phần mềm chỉnh sửa video9 tháng ago

phần mềm chỉnh sửa video9 tháng agoChuyển Văn Bản Thành Video Miễn Phí với Stable Diffusion

-

Các phần mềm nâng cao ảnh bằng AI10 tháng ago

Các phần mềm nâng cao ảnh bằng AI10 tháng agoBiến Ảnh Tĩnh Thành Video “Sống Động”: OmniHuman-1 – Công Nghệ Lip Sync AI Đột Phá!

-

Tin Nhanh11 tháng ago

Tin Nhanh11 tháng agoKhám Phá Công Cụ Ghép Ảnh Vào Video Hấp Dẫn Không Thể Bỏ Qua